如何爬取小红书数据

小红书是一个国内颇受欢迎的社交化妆品电商平台,许多人都希望通过爬取小红书数据来获取所需的信息。下面介绍一下如何使用Python来爬取小红书数据。

步骤一:安装爬虫框架

首先需要在电脑上安装一个爬虫框架,比较常用的有Scrapy和BeautifulSoup等,这里以Scrapy为例进行介绍。

步骤二:创建项目

接下来需要在命令行中创建一个Scrapy项目,具体命令如下:

scrapy startproject project_name cd project_name

步骤三:编写爬虫程序

创建好项目后,需要编写一个自定义的Spider(爬虫)来实现对小红书数据的爬取。具体步骤如下:

在项目的spiders文件夹下创建一个Python文件,命名为spider_name.py在该文件中定义一个类,并继承Scrapy的Spider类在该类中定义下面几个属性:name:爬虫名称start_urls:起始URL列表allowed_domains:允许的域名列表编写parse()方法,用于解析响应并提取所需信息。

步骤四:运行爬虫程序

编写好爬虫程序后,可以使用以下命令来运行该爬虫:

scrapy crawl spider_name总结

以上就是爬取小红书数据的基本步骤。但需要注意的是,如果未经允许就爬取小红书数据,可能会涉嫌违法,所以在爬取前需要了解相关法律法规,并遵守相关规定。

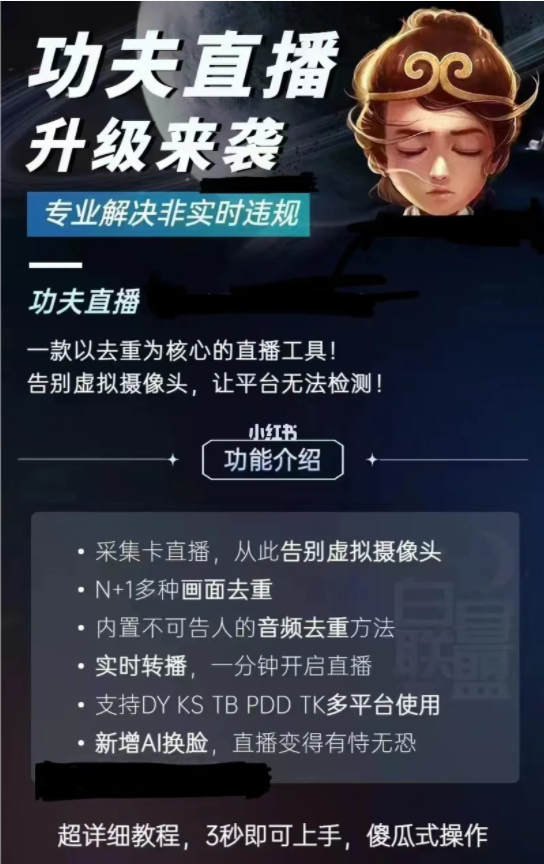

加入电商圈子与更多电商工具添加微信:lisugushi1 ,请猛戳这里→立刻添加

发表评论