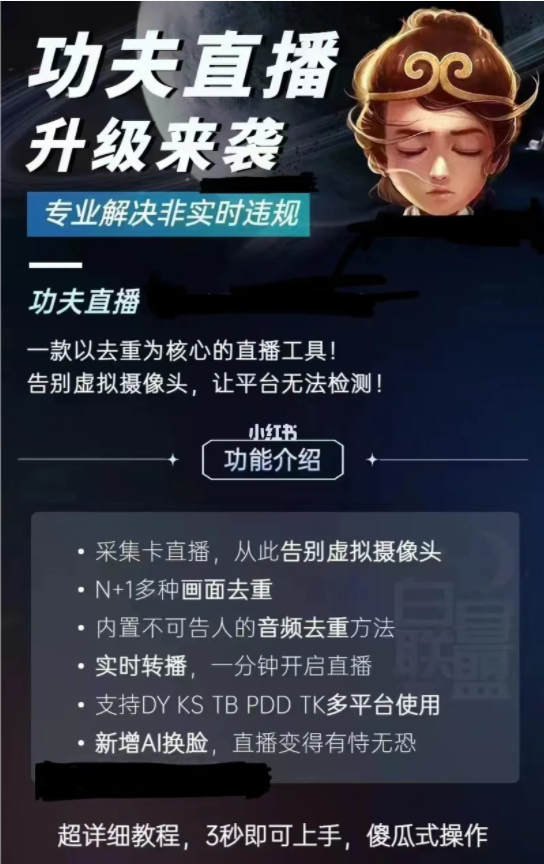

小红书是一款知名的社交电商平台,用户可以在该平台上分享生活经验、购物心得、时尚搭配等各种话题,因此,有人在Python上开发了小红书爬虫,用于获取平台上的相关信息。Python作为一种强大而简单易学的编程语言,有着丰富的库和框架,适合用于开发爬虫。爬虫可以模拟用户的访问行为,从网页中获取所需的内容并进行存储和分析。对于小红书的爬虫,一般分为以下几个步骤:1. 确定需求和目标:明确需要获取的信息,例如用户信息、帖子内容、评论等。2. 确定爬取方式:通过分析小红书的网页结构和API接口,确定合适的爬取方式。可以使用第三方库如Requests或Scrapy来发送HTTP请求和解析网页内容。3. 编写代码实现爬虫逻辑:根据需求编写代码,模拟用户的访问行为,发送请求,提取所需数据并进行存储和处理。4. 处理反爬机制:一些网站为了防止爬虫,可能会设置反爬机制如验证码、登录等,需要进行相应处理,以确保爬取的顺利进行。5. 数据存储和分析:将爬取到的数据进行存储,可以选择使用数据库或者本地文件进行存储。对数据进行分析和处理,得到所需的结果。需要注意的是,爬虫的合法性和道德性也是需要考虑的问题。在开发爬虫之前,应该遵守相关的法律法规和网站的使用规定,确保合法合规的爬取行为。总之,Python小红书爬虫可以帮助我们获取小红书平台上的相关信息,为用户提供更广泛的数据支持,实现个性化和有针对性的信息筛选和推荐。

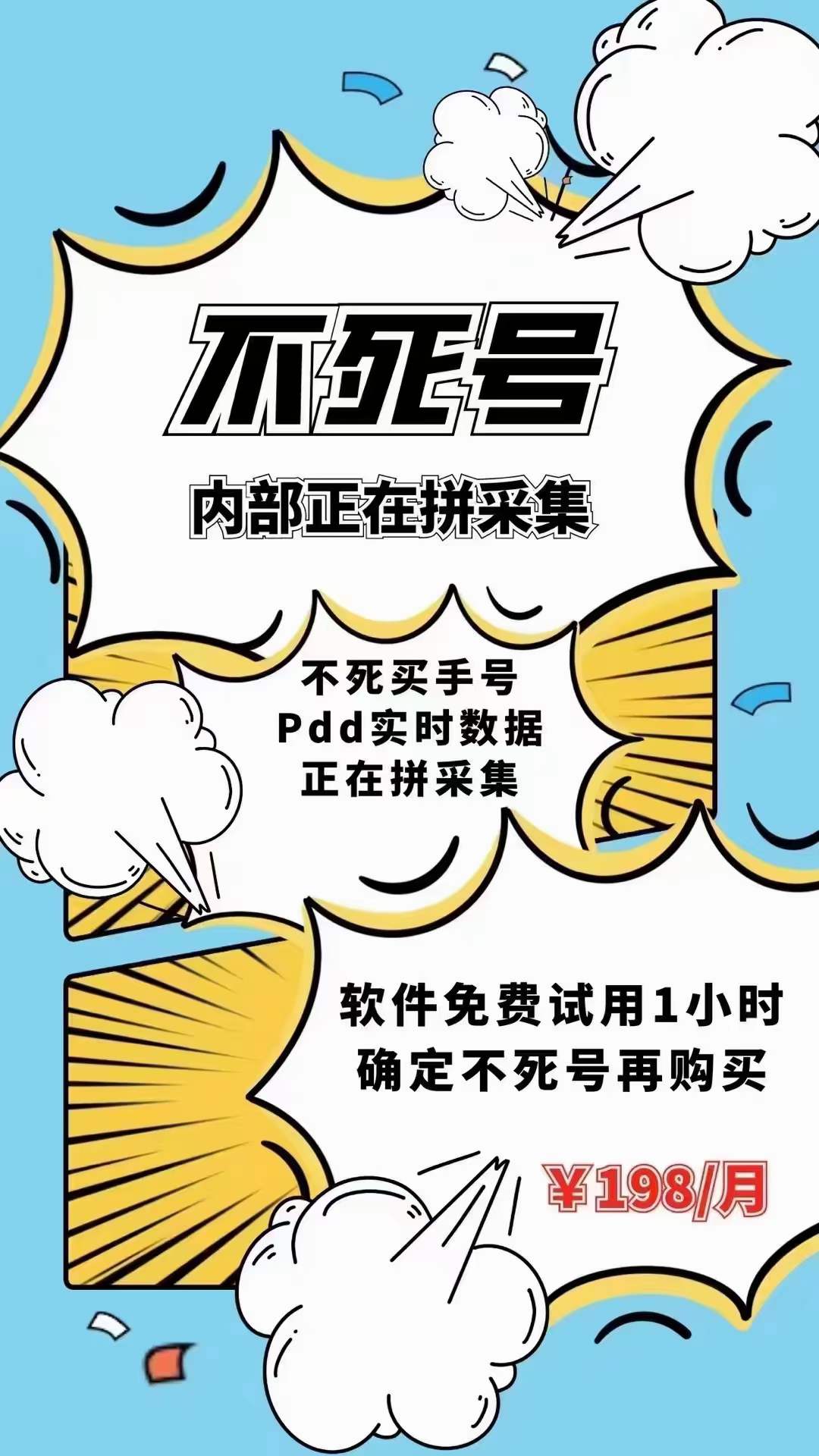

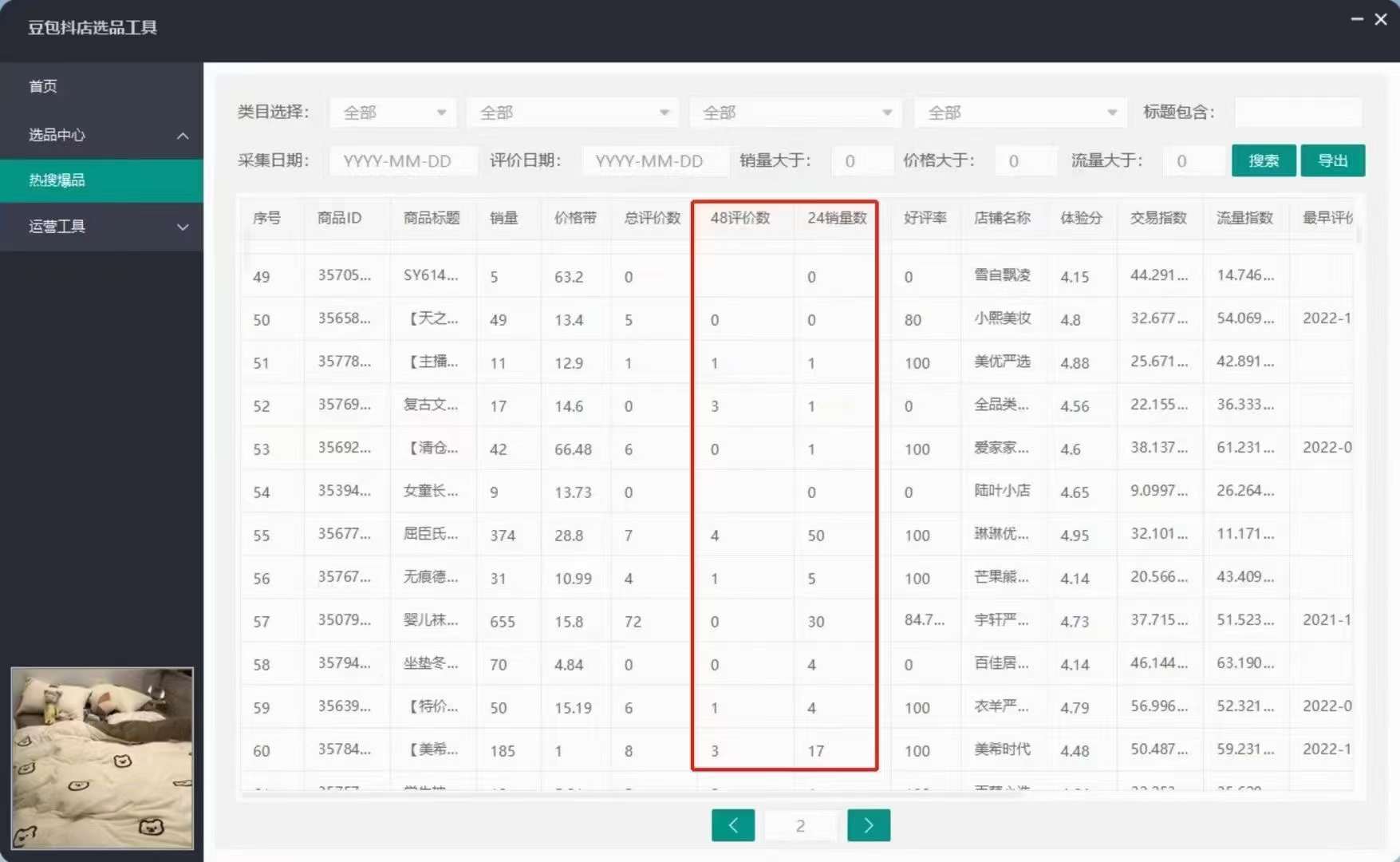

加入电商圈子与更多电商工具添加微信:lisugushi1 ,请猛戳这里→立刻添加

发表评论